目次

## イントロダクション

AI生成イメージの世界は急速に進化しており、新しいモデルと技術が創造性とPrecisionの境界を押し広げています。これらの革新の中で、ControlNetは画期的なツールとして登場し、text-to-image生成における創造プロセスの制御を強化しています。この革新的なニューラルネットワーク技術は、視覚コンテンツの作成において前例のないcontrolとPrecisionを提供し、テキストによる描写と高度にカスタマイズされたイメージのギャップを埋め続けています。

## ControlNetとは?

ControlNetは、Stable Diffusionなどのtext-to-image AIシステムの創造プロセスを洗練させ、導くために設計されたニューラルネットワークModelです。これは生成AIにおける大きな進歩を表しており、ユーザーにimage生成プロセスに対する詳細な制御を提供します。従来のtext-to-image Modelがテキストプロンプトのみに基づいて画像を生成するのに対し、ControlNetは追加のInput条件を介して視覚要素の洗練された操作が可能になりました。

## 技術アーキテクチャと機能

ControlNetの中核となる革新は、Diffusion Modelの創造力を維持しながら正確な空間制御を導入する能力にあります。エッジマップ、奥行きマップ、セグメンテーションマスク、またはポーズ推定などの追加条件付きInputを取り入れることで、ユーザーはimage生成プロセスを驚くほどのAccuracyで導くことができます。

ControlNetの中核では、Stable Diffusionのような既存のDiffusion Modelとともに動作するユニークなニューラルネットワークアーキテクチャがあります。システムは次のように動作します:

* 1. テキストプロンプトに加えて、複数のタイプの条件付きInputを受け入れる

* 2. 元のModelの生成能力を維持する

* 3. 大規模な再トレーニングなしで詳細な制御メカニズムを導入する

ControlNetの実装に対する実践的な理解を求める人々には、ビデオチュートリアル「ControlNet Stable Diffusion Tutorial In 8 Minutes」がControlNetの使用法に関する包括的なガイドを提供します。この拡張機能は、さまざまなリファレンスイメージを適用してポーズや深度などのcontrolマップを作成することで、image生成制御を強化します。Stable Diffusionのフレームワーク内でControlNetを探索したい人々のために設計されたこの簡潔なチュートリアルは、Automatic1111バージョン1.6のインストール手順、[Hugging Face](https://huggingface.co/lllyasviel/ControlNet-v1-1/tree/main)から必要なModelをダウンロードすることが含まれ、関連するユーザーインターフェースの基本を提供し、controlユニットの活性化とリファレンスイメージの操作を支援します。このビデオは、デザイナーとAI研究者の両方がControlNetが特定のtext-to-image Model内でどのように機能するかについての実用的な洞察を得るための優れた出発点として役立ちます。

## ControlNetの主要機能

* **柔軟なInput**

* エッジマップ、奥行きマップ、セグメンテーションマップ、人体のポーズなどのさまざまなInput形式を受け付ける。

* 部分的なInputをサポートしており、ユーザーは最小限の指示を提供しても影響力のある結果を見ることができる。

* **芸術的自由の保持**

* ControlNetは提供されたInputに従いながらも、AIの固有の創造性の余地を残し、ユーザーの意図とModelの解釈能力を融合させる。

* **改善された一貫性**

* user提供のデータにより厳密に従うことで、text-to-image Modelで見られる一貫性の欠如に対処し、正確なデザインにとって非常に価値がある。

* **互換性**

* Stable Diffusionのような人気のあるDiffusion Modelと連携し、既存のワークフローに簡単に統合できる。

## ControlNetの能力の実践的デモンストレーション

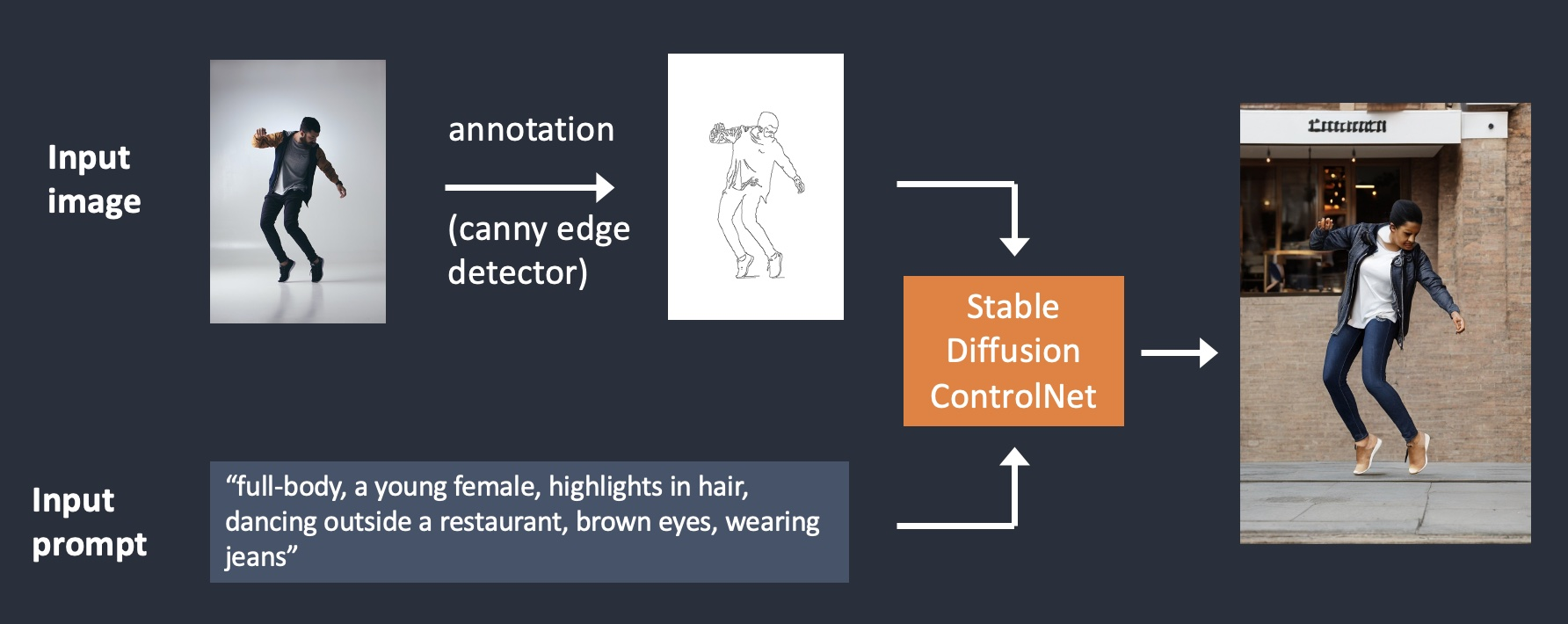

### エッジ検出制御

エッジ検出は、構造上のAccuracyを伴うimage生成のガイド方法の基本的な方法を表しています。このアプローチを通じて、ControlNetは詳細なエッジマップを条件付きInputとして利用し、ユーザーがimageの正確な構造的アウトラインを定義することを可能にします。

このImageは、Stable DiffusionでのCannyエッジ条件を用いたControlNetの力を示しています。プロセスはInput画像から始まり、写真や任意の視覚的リファレンスである可能性があります。これが構造的に正確なOutputを作成するための基盤となります。次のステップは、Cannyエッジ検出器のような技術を使用したエッジ検出を含みます。この方法は、Input画像から重要な構造的アウトラインを抽出し、被写体の輪郭とポーズを定義することに焦点を当てています。得られたエッジマップは元の画像の簡素化された線ベースのバージョンであり、生成プロセスに重要な指針を提供します。

エッジマップとともに、ユーザーは被写体の外見、環境、全体のスタイリングなどの詳細を指定するTextプロンプトを提供します。Textual Inputは常にエッジマップによって提供された構造的指導を補完するためのコンテキストおよびスタイリスティックなレイヤーを追加できます。これらのInputはStable DiffusionとControlNetを統合して処理されます。ControlNetは、生成された画像がエッジマップの構造に忠実であり続ける一方で、プロンプトの創造的な詳細を組み込むことを保証します。結果は元のポーズとプロポーションを保持しながら、ユーザーの説明に合わせてコンテキストとスタイルを変換した非常にリアルなOutputとなるでしょう。

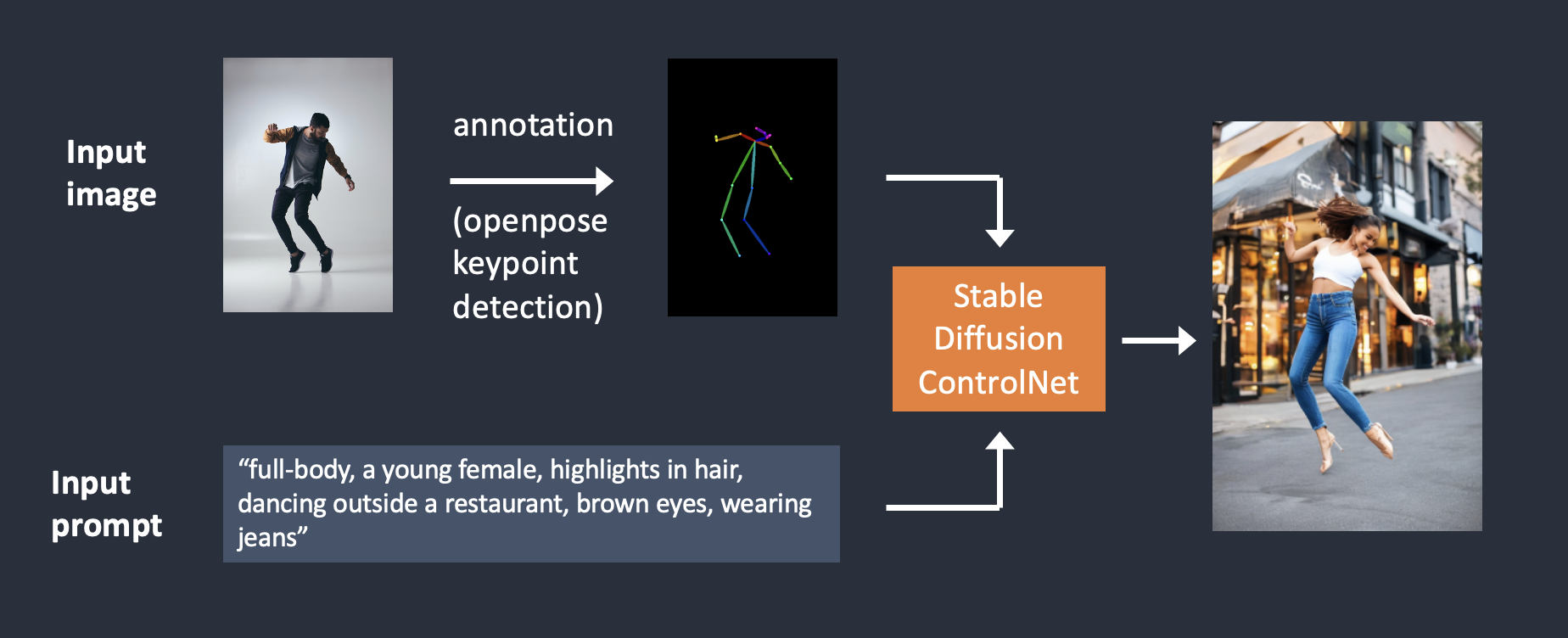

### 人体ポーズ検出と生成

人体ポーズ検出は、さらに細かいImage制御の形態を提供します。ControlNetは複雑な人体ポーズを驚くほどのAccuracyで解釈し、再現することができ、アニメーションからファッションデザインまで様々な分野で価値があります。

このImageは、AI画像生成における構造的Precisionと創造的自由を融合させる画期的な方法であるOpenPoseを使用したControlNetのワークフローを示しています。始まりはInput画像からであり、視覚的リファレンスとして機能します。次のステップでは、入力画像を分析して重要な身体の位置を表すキーポイントを抽出するOpenPoseキーポイント検出を利用します。これらのキーポイントは頭、腕、胴体、脚などに対応し、被写体の骨格のアウトラインを形成します。この骨格構造は、Controlマップとして知られ、不要な視覚的詳細を取り除きながら被写体のポーズと動きをエンコードします。構造的ガイドとして機能し、生成されたOutputが元のポーズを保持することを保証します。

並行して、Textプロンプトが生成プロセスにコンテキストおよびスタイル付けの詳細を追加します。ControlマップとTextプロンプトの両方がStable Diffusionと統合されたControlNetに供給されます。これらのInputの統合により、AIは構造的Accuracyと芸術的自由のバランスを保つことができます。Controlマップは、Inputのキーポイントおよび体のプロポーションに従った生成画像を保証し、Textプロンプトはキャラクターの特徴、衣装、背景などの詳細を決定します。

上記のワークフローはすべて、Stable Diffusionを使用したControlNetの多様性を強調し、キャラクターデザイン、アニメーション、アートにおける特定のポーズの再現などの用途において強力なツールです。さらに、ControlNetは3次元の空間関係に対する制御を可能にするDepthマップConditioningや、Specific Image領域のGranular Controlを提供するSegmentationマスクControlを行うこともできます。構造的指導と創造的Inputをシームレスに統合することで、ControlNetは常にユーザーが正確で視覚的に印象的な結果を達成することを許可します。

## 学ぶ場所

ControlNetについてさらに深く理解し、その能力を試してみるためには、以下のリソースをチェックしてください:

* **[ControlNet GitHubリポジトリ](https://github.com/lllyasviel/ControlNet)**: 技術的な詳細を探り、オープンソースコードにアクセスしてください。

* **[Runway ML](https://www.runwayml.com/)**: このユーザーフレンドリーな創造プラットフォームでControlNetを試してみましょう。

* **[Hugging Face](https://huggingface.co/docs/diffusers/en/using-diffusers/controlnet)**: ControlNetと様々なAIツールについて学び、事前学習されたControlNet Modelを見つけてください。

* **[Stable Diffusion](https://stability.ai/)**: ControlNetが輝くエコシステムを発見してください。

## 結論

ControlNetは生成AIにおける変革の最前線に立ち、image生成における前例のない制御と創造性を提供します。高度なConditioningメカニズムを提供することで、この技術は複数の領域にわたるクリエイターに、最も複雑な視覚コンセプトをRemarkableなPrecisionで実現する力を与えます。

AI主導の創造性が主流となるにつれ、ControlNetのようなツールはデザインの民主化において重要な役割を果たします。ユーザーInputとAIの生成能力の組み合わせは、Precisionと創造性が共存するバランスの取れたアプローチを保証します。さらなる開発によって、ControlNetはVideo生成や3D Model化など他のモダリティと統合され、その影響を拡大する可能性があります。

そのため、ControlNetの可能性を探り、新たな創造性のレベルを解き放ちましょう!!!